Precisión vs Exactitud: Definición, diferencias y ejemplos en mediciones

Precisión vs Exactitud: descubre definiciones, diferencias claras y ejemplos prácticos en mediciones para mejorar resultados científicos e industriales.

La exactitud y la precisión de las mediciones tienen un significado especial en los campos de la ciencia, la ingeniería, la industria y la estadística. Aunque en lenguaje coloquial a veces se usan como sinónimos, en metrología y estadística estos términos describen conceptos diferentes y complementarios.

Definiciones

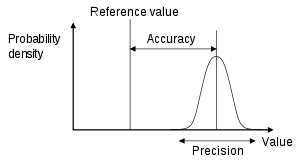

- La exactitud (o accuracy) de un sistema de medición es el grado en que el valor promedio de las mediciones se aproxima al valor real (verdadero) de una cantidad. Es decir, indica qué tan cerca está la medición del valor verdadero.

- La precisión (o precision) de un sistema de medición es el grado en que las mediciones repetidas dan resultados consistentes entre sí. Se relaciona con la dispersión o variabilidad de las mediciones.

Diferencias clave

Resumen de las diferencias prácticas entre ambos conceptos:

- Exactitud: se refiere al sesgo o error sistemático. Un instrumento con buena exactitud produce medidas centradas en el valor verdadero.

- Precisión: se refiere a la reproducibilidad o dispersión (error aleatorio). Un instrumento preciso tiene poca variabilidad entre repeticiones.

- Un sistema puede ser:

- Exacto pero no preciso: medidas centradas en el valor verdadero pero muy dispersas.

- Preciso pero no exacto: medidas muy agrupadas pero alejadas del valor verdadero (presencia de sesgo).

- Ni exacto ni preciso: dispersas y lejos del valor verdadero.

- Ambas cosas: agrupadas y centradas en el valor verdadero (ideal).

Analogía visual

Un ejemplo clásico para visualizar la diferencia es el blanco de tiro:

- Tiros agrupados cerca del centro: alto grado de exactitud y precisión.

- Tiros agrupados entre sí pero lejos del centro: precisos pero no exactos (existe un sesgo).

- Tiros dispersos alrededor del centro: exactitud moderada pero baja precisión.

- Tiros dispersos y lejos del centro: ni exactitud ni precisión.

Ejemplos prácticos

- Una balanza mal calibrada que siempre marca 0.5 kg más: mediciones precisas (si son repetibles) pero no exactas (sesgo sistemático).

- Una técnica analítica con alta variabilidad entre réplicas: imprecisa, aunque el promedio pueda coincidir con el valor verdadero.

- En un experimento con error en el procedimiento (p. ej., lectura sistemáticamente sesgada), aumentar el tamaño de la muestra suele aumentar la precisión (reduce el error aleatorio) pero no mejora la exactitud. El resultado será un conjunto de medidas consistentes aunque inexactas hasta que se elimine el error sistemático.

Cómo se cuantifican

- Sesgo (bias): se calcula como la diferencia entre la media de las mediciones y el valor verdadero. Es una medida de inexactitud sistemática.

- Precisión: suele cuantificarse mediante la desviación estándar (σ) o la varianza (σ2) de las mediciones repetidas. Menor desviación estándar = mayor precisión.

- Error cuadrático medio (MSE): combina sesgo y variabilidad: MSE = Var + (Bias)². Un sistema que minimiza el MSE es deseable cuando se busca equilibrio entre sesgo y variabilidad.

Fuentes de error y su corrección

- Errores sistemáticos: causan falta de exactitud. Fuentes: calibración incorrecta, métodos mal aplicados, interferencias constantes. Corrección: calibrar instrumentos, revisar el método, eliminar sesgos conocidos.

- Errores aleatorios: afectan la precisión. Fuentes: fluctuaciones ambientales, resolución limitada del instrumento, variaciones en la ejecución. Corrección: mejorar la instrumentación, controlar el entorno, promediar más replicados.

- Repetibilidad y reproducibilidad: la repetibilidad mide la variación al mismo operador y condiciones; la reproducibilidad, la variación entre operadores o laboratorios. Ambas influyen en la precisión práctica de un método.

Cómo mejorar cada una

- Para mejorar la exactitud: calibrar el instrumento con estándares trazables, corregir sesgos, validar métodos frente a referencias conocidas.

- Para mejorar la precisión: aumentar el número de réplicas, usar instrumentos con menor incertidumbre, estandarizar procedimientos y controlar condiciones experimentales.

Importancia práctica

En investigación y producción, distinguir entre exactitud y precisión ayuda a decidir acciones correctivas apropiadas: aumentar la muestra o el control de calidad para reducir la variabilidad, o recalibrar y corregir el método para eliminar sesgos. Un sistema de medición es válido si es exacto y preciso. Los términos relacionados incluyen el sesgo (efectos no aleatorios o dirigidos causados por un factor o factores no relacionados con la variable independiente) y el error (variabilidad aleatoria).

Entender y medir la exactitud y la precisión es esencial para interpretar correctamente resultados, establecer incertidumbres y tomar decisiones basadas en datos fiables.

Exactitud: la proximidad de los resultados al valor real Precisión: la repetibilidad de las mediciones

Temas relacionados

La terminología también se aplica a las mediciones indirectas, es decir, a los valores obtenidos por un procedimiento computacional a partir de los datos observados.

Además de la exactitud y la precisión, las mediciones también pueden tener una resolución de medición, que es el cambio más pequeño en la cantidad física subyacente que produce una respuesta en la medición.

Diferentes significados de "precisión

La palabra "precisión" también se refiere a lo fina que es la medición, como la resolución de la medida, como por ejemplo al metro, centímetro o yarda más cercano, pie, pulgada o nanómetro.

En el caso de la reproducibilidad total, como cuando se redondea un número a un número de coma flotante representable, la palabra precisión tiene un significado no relacionado con la reproducibilidad. Por ejemplo, en la norma IEEE 754-2008, significa el número de bits en el significante (número de dígitos en la cantidad), por lo que se utiliza como una medida para la precisión relativa con la que se puede mostrar un número.

Páginas relacionadas

Preguntas y respuestas

P: ¿Qué significan los términos "exactitud" y "precisión" en los campos de la ciencia, la ingeniería, la industria y la estadística?

R: La exactitud de un sistema de medición es lo cerca que se aproxima al valor real de una cantidad, mientras que la precisión de un sistema de medición es el grado en que mediciones repetidas dan los mismos resultados.

P: ¿Puede un sistema de medición ser exacto pero no preciso?

R: Sí, un sistema de medición puede ser exacto pero no preciso.

P: ¿Puede un sistema de medición ser preciso pero no exacto?

R: Sí, un sistema de medición puede ser preciso pero no exacto.

P: ¿Puede un sistema de medición ser a la vez exacto y preciso?

R: Sí, un sistema de medición puede ser a la vez exacto y preciso.

P: ¿Cómo afecta el aumento del tamaño de la muestra a la precisión y exactitud de un experimento?

R: Aumentar el tamaño de la muestra suele aumentar la precisión pero no mejora la exactitud si hay un error en la forma de realizar el experimento.

P: ¿Qué debe hacerse para mejorar la precisión si existe un error sistemático en un sistema de medición?

R: Eliminar el error sistemático mejora la precisión.

P: ¿Cuál es la diferencia entre sesgo y error en el contexto de los sistemas de medición?

R: El sesgo se refiere a los efectos no aleatorios o dirigidos causados por un factor o factores no relacionados con la variable independiente, mientras que el error se refiere a la variabilidad aleatoria.

Buscar dentro de la enciclopedia